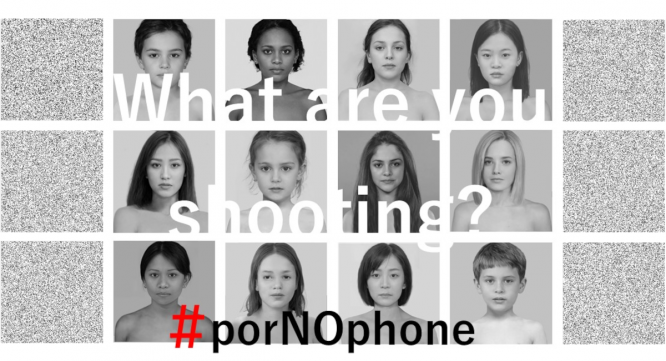

ヌードやポルノをスマホ撮影させない AI(人工知能)を、iOSとAndroidの標準機能に【#porNOphoneキャンペーン】 (1/3ページ)

性的画像記録の撮影・拡散被害が、中高生のスマホを中心に拡大している。インターネット上に流出した画像の削除要請事業を世界的におこなう特定非営利活動法人 ぱっぷす(本部:東京都文京区、理事長:金尻カズナ)が、スマホOSベンダー2社、AppleおよびGoogleに向け、デフォルトではヌードやポルノ画像を撮影させないためのAI開発とスマートフォン標準機能化を要望すると発表。「デジタル性暴力をみんなが知って、社会が変わるプロジェクト」として、porNOphoneキャンペーンを展開するとともに、クラウドファンディングを通してキャンペーン支援者と賛同者を募っている。「CAMPFIRE」クラウドファンディング 2021年2月8日まで⇒ https://camp-fire.jp/projects/view/335757

警察庁資料から浮かび上がるのは、私事性的画像にかかわる事案の被害者、加害者、ともに学齢期の10代から20代が多く、児童ポルノ事犯では中学生が最多であることーー。自撮りから始まって犯罪に巻き込まれるケースも後を絶たない。

ぱっぷすが依頼を受け、拡散した性的画像記録を探し出し、削除要請をかけるまでには数多くの困難がある。過半数が日本向きに配信している国外サイトであり、オフショア・ホスティング(ベルヌ条約に加盟していない地域のためコンテンツ削除要請に対応する義務が生じない)やコンテンツ・デリバリー・ネットワーク(CDN:高度に分散されたサーバー群)、仮想通貨決済など、匿名性の高い相手を確認して削除要請をかけなければならないからだ。また、現行法では、頒布(投稿)・販売者が主犯、撮影者が従犯となるため、投稿者を特定できない以上は刑事事件化も難しい。